网站架构演变

1. 问题

学习从单机架构到集群架构的演变之路:

-

单机版LNMP

-

独立数据库服务器

-

Web服务器集群与Session保持

-

动静分离、数据库集群

-

各种缓存服务器 业务模型

2. 步骤

此案例主要是学习网站架构演变的过程,以拓扑图和理论为主,具体实现还需要结合具体的软件。

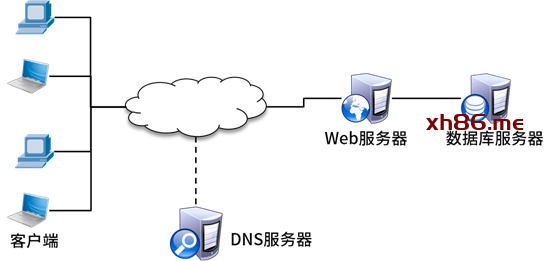

步骤一:单机版LNMP

单机版网站,拓扑如图-1所示。

用户量少时使用,简单、成本低、存在单点故障。

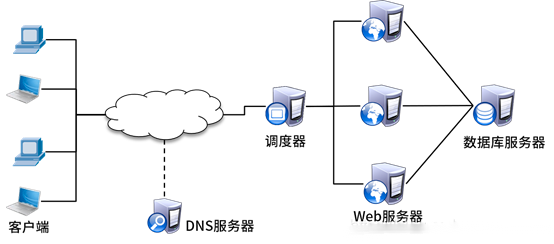

步骤二:独立数据库服务器

独立数据库服务器是将网站静态文件、代码文件等资料与数据库分离的架构,当用户量增加时单机的处理能力有限,PHP或JAVA代码的执行需要消耗大量CPU资源,数据库的增删改查需要调用大量的内存资源,将两者分离可以减轻服务器的压力,其拓扑结构如图-2所示。

Web服务器和数据库服务器的压力都可以得到有效改善,访问量有所增加。但是服务器依然存在单点故障问题。

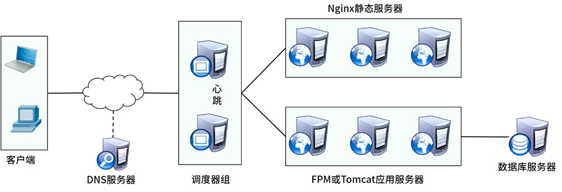

步骤三:Web服务器集群与Session保持

我们可以通过Nginx、Haproxy代理服务器实现Web负载均衡集群,也可以使用LVS调度器实现Web负载均衡集群。部署完Web集群后还需要考虑如何进行Session会话保持,方法很多,如:根据源IP保持,代理服务器重写Cookie信息,共享文件系统保存session,使用数据库共享session等等。该架构拓扑如图-3所示。

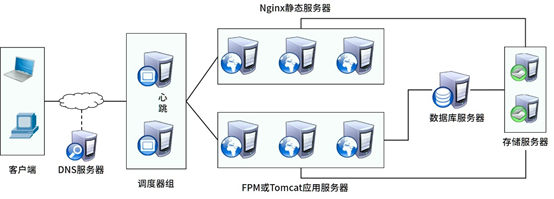

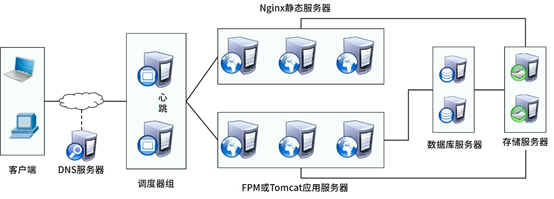

但是如果只有一台调度器依然会导致单点故障的问题,因此还需要使用Keepalived或Heartbeat之类的软件进行高可用配置,如图-4所示。

对于网站内容而言可以分离为动态页面和静态页面,静态页面就需要数据文件,动态页面则需要CPU解析代码,需要消耗大量的CPU资源,因此可以将静态和动态分离为两组服务器,动态页面有脚本代码组成,是一种基于网页的应用程序,因此这一组服务器也称为应用服务器,其架构如图-5所示。

步骤四:动静分离、数据库集群

随着服务器的增加,虽然性能与并发量得到了明显的提升,但是数据的一致性、管理的便利性成为了新的问题,因此就需要增加统一的存储服务器,实现数据的同步一致,可以使用NFS,GlusterFS、Ceph等软件实现该功能,其架构如图-6所示。

此时所有应用服务器都连接一台数据库服务器进行读写操作,而且后期随着数据库中的数据不断增加,会导致数据库成为整个网站的瓶颈!这就需要我们对数据进行分库分表,创建数据库主从或者数据库集群,实现读写分离,其拓扑如图-7所示。

步骤五:缓存服务器与业务模型

对于静态数据我们可以通过varnish、squid或者nginx进行缓存,将数据缓存到距离用户更近的位置,构建CDN(内容分发网络)架构。

对于传统的SQL数据库而言,我们也可以通过增加NoSQL数据库,实现数据缓存的功能,提升数据库的访问速度。

备注:数据库相关知识在第三阶段课程有详细介绍,第二阶段项目暂时不做数据库优化。

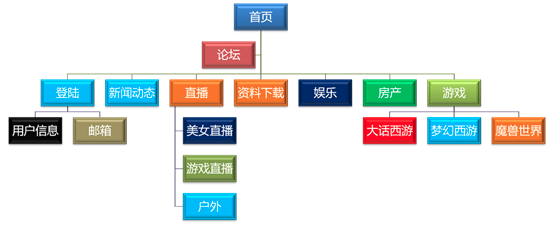

最后,基于前面的架构,我们还可以将网站按照公司的业务进行分离,每个业务都可以是一个独立的集群,如图-8所示。

LNP+Mariadb数据库分离

1. 问题

部署LNP+Mariadb实现数据库与Web服务器分离,实现以下目标:将旧的数据库备份,迁移到新的服务器修改配置调用新的数据库服务器。

2.方案

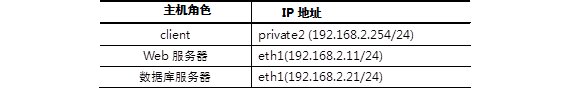

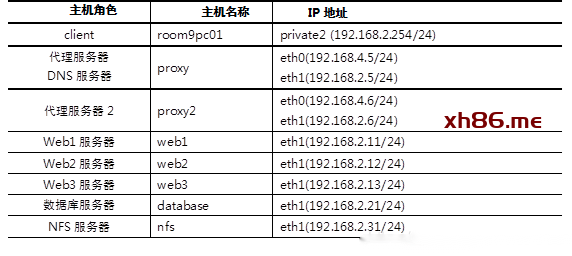

实验拓扑如图-9所示,做具体实验前请先配置好环境。

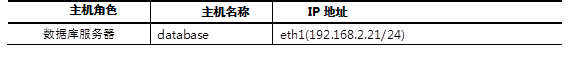

主机配置如表-1所示。

3. 步骤

实现此案例需要按照如下步骤进行。

步骤一:部署数据库服务器

1)准备一台独立的服务器,安装数据库软件包

[root@database ~]# yum -y install mariadb mariadb-server mariadb-devel

[root@database ~]# systemctl start mariadb

[root@database ~]# systemctl enable mariadb

2)将之前单机版LNMP网站中的数据库迁移到新的数据库服务器。

登陆192.168.2.11主机,备份数据库并拷贝给新的服务器,关闭旧的数据库服务。

[root@centos7 ~]# mysqldump wordpress > wordpress.bak

[root@centos7 ~]# scp wordpress.bak 192.168.2.21:/root/

[root@centos7 ~]# systemctl stop mariadb

[root@centos7 ~]# systemctl disable mariadb

登陆192.168.2.21主机,使用备份文件还原数据库。

创建空数据库:

[root@database ~]# mysql

MariaDB [(none)]> create database wordpress character set utf8mb4;

MariaDB [(none)]> exit

使用备份文件还原数据:

[root@database ~]# mysql wordpress < wordpress.bak

重新创建账户并授权访问:

[root@database ~]# mysql

MariaDB [(none)]> grant all on wordpress.* to wordpress@’%’ identified by ‘wordpress’;

MariaDB [(none)]> flush privileges;

MariaDB [(none)]> exit

3)修改wordpress网站配置文件,调用新的数据库服务器。

WordPress在第一次初始化操作时会自动生产配置文件:wp-config.php,登陆192.168.2.11修改该文件即可调用新的数据库服务。

[root@centos7 ~]# vim /usr/local/nginx/html/wp-config.php

修改前内容如下:

define(‘DB_HOST’, ‘192.168.2.11’);

修改后内容如下:

define(‘DB_HOST’, ‘192.168.2.21’);

步骤二:客户端测试

1)客户端使用浏览器访问wordpress网站。

[root@client ~]# firefox http://192.168.2.11

Web服务器集群

1. 问题

使用HAProxy部署Web服务器集群,实现以下目标:

-

部署三台Web服务器

-

迁移网站数据,使用NFS实现数据共享

-

部署HAProxy代理服务器实现负载均衡

-

部署DNS域名解析服务器

2. 方案

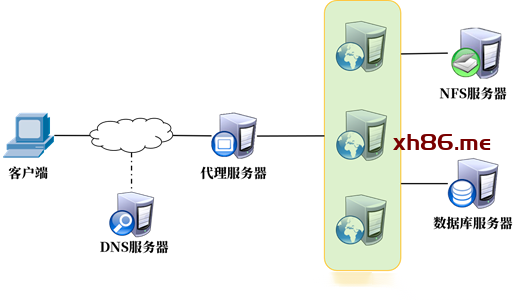

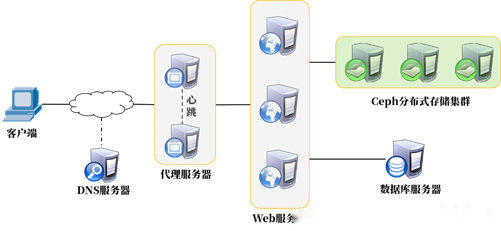

实验拓扑如图-10所示,做具体实验前请先配置好环境。

备注:实际操作中DNS服务代理服务器部署在同一台主机上(节约虚拟机资源)。主机配置如表-2所示。

3. 步骤

实现此案例需要按照如下步骤进行。

步骤一:部署web2和web3服务器

1)安装LNP软件包

[root@web2 ~]# yum -y install gcc pcre-devel openssl-devel

[root@web2 lnmp_soft]# tar -xf nginx-1.12.2.tar.gz

[root@web2 lnmp_soft]# cd nginx-1.12.2/

[root@web2 nginx-1.12.2]# ./configure

–with-http_ssl_module

–with-http_stub_status_module

[root@web2 nginx-1.12.2]# make && make instal

[root@web2 ~]# yum -y install php php-fpm php-mysql mariadb-devel

[root@web3 ~]# yum -y install gcc pcre-devel openssl-devel

[root@web3 lnmp_soft]# tar -xf nginx-1.12.2.tar.gz

[root@web3 lnmp_soft]# cd nginx-1.12.2/

[root@web3 nginx-1.12.2]# ./configure

–with-http_ssl_module

–with-http_stub_status_module

[root@web3 nginx-1.12.2]# make && make instal

[root@web3 ~]# yum -y install php php-fpm php-mysql mariadb-devel

2)修改nginx配置实现动静分离(web2和web3操作)

web2修改默认首页index.php,配置两个location实现动静分离。

[root@web2 ~]# vim /usr/local/nginx/conf/nginx.conf

location / {

root html;

index index.php index.html index.htm;

}

location ~ .php$ {

root html;

fastcgi_pass 127.0.0.1:9000;

fastcgi_index index.php;

include fastcgi.conf;

}

web3修改默认首页index.php,配置两个location实现动静分离。

[root@web3 ~]# vim /usr/local/nginx/conf/nginx.conf

location / {

root html;

index index.php index.html index.htm;

}

location ~ .php$ {

root html;

fastcgi_pass 127.0.0.1:9000;

fastcgi_index index.php;

include fastcgi.conf; }

3)启动相关服务

[root@web2 ~]# echo “/usr/local/nginx/sbin/nginx” >> /etc/rc.local

[root@web2 ~]# chmod +x /etc/rc.local

[root@web2 ~]# /usr/local/nginx/sbin/nginx

[root@web2 ~]# systemctl start php-fpm #启动php-fpm服务

[root@web2 ~]# systemctl enable php-fpm

[root@web3 ~]# echo “/usr/local/nginx/sbin/nginx” >> /etc/rc.local

[root@web3 ~]# chmod +x /etc/rc.local

[root@web3 ~]# /usr/local/nginx/sbin/nginx

[root@web3 ~]# systemctl start php-fpm #启动php-fpm服务

[root@web3 ~]# systemctl enable php-fpm

附加知识:systemd!!!

源码安装的软件默认无法使用systemd管理,如果需要使用systemd管理源码安装的软件需要手动编写服务的service文件(编写是可以参考其他服务的模板文件)。以下是nginx服务最终编辑好的模板。

Service文件存储路径为/usr/lib/system/system/目录。

[root@centos7 ~]# vim /usr/lib/systemd/system/nginx.service

[Unit]

Description=The Nginx HTTP Server

#描述信息

After=network.target remote-fs.target nss-lookup.target

#指定启动nginx之前需要其他的其他服务,如network.target等

[Service]

Type=forking

#Type为服务的类型,仅启动一个主进程的服务为simple,需要启动若干子进程的服务为forking

ExecStart=/usr/local/nginx/sbin/nginx

#设置执行systemctl start nginx后需要启动的具体命令.

ExecReload=/usr/local/nginx/sbin/nginx -s reload

#设置执行systemctl reload nginx后需要执行的具体命令.

ExecStop=/bin/kill -s QUIT ${MAINPID}

#设置执行systemctl stop nginx后需要执行的具体命令.

[Install] WantedBy=multi-user.target

步骤二:部署NFS,将网站数据迁移至NFS共享服务器

1)部署NFS共享服务器

[root@nfs ~]# yum install nfs-utils

[root@nfs ~]# mkdir /web_share

[root@nfs ~]# vim /etc/exports

/web_share 192.168.2.0/24(rw,no_root_squash)

[root@nfs ~]# systemctl restart rpcbind

[root@nfs ~]# systemctl eanble rpcbind

NFS使用的是随机端口,每次启动NFS都需要将自己的随机端口注册到rpcbind服务,这样客户端访问NFS时先到rpcbind查询端口信息,得到端口信息后再访问NFS服务。

[root@nfs ~]# systemctl restart nfs

[root@nfs ~]# systemctl enable nfs

2)迁移旧的网站数据到NFS共享服务器

将web1(192.168.2.11)上的wordpress代码拷贝到NFS共享。

[root@web1 ~]# cd /usr/local/nginx/

[root@web1 nginx]# tar -czpf html.tar.gz html/

[root@web1 nginx]# scp html.tar.gz 192.168.2.31:/web_share/

登陆nfs服务器,将压缩包解压

[root@nfs ~]# cd /web_share/

[root@nfs web_share]# tar -xf html.tar.gz

3)所有web服务器访问挂载NFS共享数据。

[root@web1 ~]# rm -rf /usr/local/nginx/html/*

[root@web1 ~]# yum -y install nfs-utils

[root@web1 ~]# echo “192.168.2.31:/web_share/html /usr/local/nginx/html/ nfs defaults 0 0” >> /etc/fstab

[root@web1 ~]# mount -a

[root@web2 ~]# yum -y install nfs-utils

[root@web2 ~]# echo “192.168.2.31:/web_share/html /usr/local/nginx/html/ nfs defaults 0 0” >> /etc/fstab

[root@web2 ~]# mount -a

[root@web3 ~]# yum -y install nfs-utils

[root@web3 ~]# echo “192.168.2.31:/web_share/html /usr/local/nginx/html/ nfs defaults 0 0” >> /etc/fstab

[root@web3 ~]# mount -a

步骤三:部署HAProxy代理服务器

1)部署HAProxy

安装软件,手动修改配置文件,添加如下内容。

[root@proxy ~]# yum -y install haproxy

[root@proxy ~]# vim /etc/haproxy/haproxy.cfg

listen wordpress *:80

balance roundrobin

server web1 192.168.2.11:80 check inter 2000 rise 2 fall 3

server web2 192.168.2.12:80 check inter 2000 rise 2 fall 3 s

erver web3 192.168.2.13:80 check inter 2000 rise 2 fall 3

[root@proxy ~]# systemctl start haproxy

[root@proxy ~]# systemctl enable haproxy

步骤三:部署DNS域名服务器

1)安装DNS相关软件(192.168.4.5操作)。

[root@proxy ~]# yum -y install bind bind-chroot

2)修改主配置文件,添加zone。

[root@proxy ~]# vim /etc/named.conf

options {

listen-on port 53 { any; }; #服务监听的地址与端口

directory “/var/named”; #数据文件路径

allow-query { any; }; #允许任何主机访问DNS服务

… …

};

zone “lab.com” IN { #定义正向区域

type master;

file “lab.com.zone”;

};

#include “/etc/named.rfc1912.zones”;

#注释掉改行 #include “/etc/named.root.key”; #注释掉改行

[root@proxy ~]# named-checkconf /etc/named.conf #检查语法

3)修改正向解析记录文件。

注意:保留文件权限。

[root@proxy named]# cp -p /var/named/named.localhost /var/named/lab.com.zone

[root@proxy named]# vim /var/named/lab.zone

$TTL 1D @

IN SOA @ rname.invalid. (

0 ; serial

1D ; refresh

1H ; retry

1W ; expire

3H ) ; minimum

@ NS dns.lab.com.

dns A 192.168.4.5 www A 192.168.4.5

4)启动服务

[root@proxy named]# systemctl start named

[root@proxy named]# systemctl enable named

5)客户端修改DNS解析文件

提示:做完实验修改回原始内容。

[root@room9pc01 data]# cat /etc/resolv.conf

# Generated by NetworkManager

search tedu.cn

nameserver 192.168.4.5

nameserver 172.40.1.10

nameserver 192.168.0.220

步骤四:修改wordpress配置文件

1)修改wp-config.php

在define(‘DB_NAME’, ‘wordpress’)这行前面添加如下两行内容:

[root@web3 html]# vim /usr/local/nginx/html/wp-config.php

define(‘WP_SITEURL’, ‘http://www.lab.com’);

define(‘WP_HOME’, ‘http://www.lab.com’);

如果不添加这两行配置,浏览器访问网站某个子页面后,URL会固定到某一台后端服务器不轮询。

附加知识(常见面试题)

什么是灰度发布?

答:灰度发布(又名金丝雀发布)是指在黑与白之间,能够平滑过渡的一种发布方式。

让一部分用户继续用产品特性A,一部分用户开始用产品特性B,如果用户对B没有什么反对意见,那么逐步扩大范围,把所有用户都迁移到B上面来。灰度发布可以保证整体系统的稳定,在初始灰度的时候就可以发现、调整问题,以保证其影响度。灰度期:灰度发布开始到结束期间的这一段时间,称为灰度期。

DNS服务器有哪些种,其使用的端口为多少?

答:有 根DNS、一级DNS、二级DNS、三级DNS、缓存DNS;主DNS服务器、从DNS服务器;端口:53

从日志/opt/bjca3/logs/ca_access.log中截取14点到16点的日志,将截取的日志导入到/tmp/ca_access.txt中,日志格式如下:

答:awk ‘$4>“13:00:00”&&$4<=“16:59:00”’ ca_access.log

监控检查,使用ping命令编写脚本来查询一组IP地址同时检测他们是否处于活跃状态。要求(range:192.168.1.200-192.168.1.220,一个IP发送4个ping包,ping的过程不能输出信息到终端)?

答:

#!/bin/bash

for i in {200..220}

do

ping -c 4 -i 0.2 -W 1 192.168.1.$i &>/dev/null

if [ $? -ne 0 ];then

echo “192.168.1.$i is down”

fi

done

假设nginx的访问日志格式如下,统计访问页面前10位的IP数?

答:

awk ‘{IP[$1]++} END{for(i in IP){print i,IP[i]}}’ access.log

| sort -n | tail -10

请列举出10个以上的你所知晓的SQL语句?

参考答案:

insert select delete update create show drop grant revoke load data create view

如何切换到某个数据库,并在上面工作?

答:use 库名;

列出数据库内的所有表?

答:show tables;

如何删除表、删除数据库?

答:drop table 表名;drop database 库名;

如何列出表”xrt”内name域值为”tecmint”,web_address域值为”tecmint.com”的所有数据?

答:

select * from xrt where name=”tecmint” and web_address=”tecmint.com”;

Keepalived高可用

1. 问题

部署两台代理服务器,实现如下效果:

-

利用keepalived实现两台代理服务器的高可用

-

配置VIP为192.168.4.80

-

修改对应的域名解析记录

2. 方案

实验拓扑如图-1所示,做具体实验前请先配置好环境。

备注:实际操作中DNS服务代理服务器部署在同一台主机上(节约虚拟机资源)。主机配置如表-1所示。

3. 步骤

实现此案例需要按照如下步骤进行。

步骤一:配置第二台代理服务器

1)部署HAProxy

安装软件,手动修改配置文件,添加如下内容。

[root@proxy2 ~]# yum -y install haproxy

[root@proxy2 ~]# vim /etc/haproxy/haproxy.cfg

listen wordpress *:80

balance roundrobin

server web1 192.168.2.11:80 check inter 2000 rise 2 fall 3

server web2 192.168.2.12:80 check inter 2000 rise 2 fall 3

server web3 192.168.2.13:80 check inter 2000 rise 2 fall 3

[root@proxy2 ~]# systemctl start haproxy

[root@proxy2 ~]# systemctl enable haproxy

步骤二:为两台代理服务器配置keepalived

1)配置第一台代理服务器proxy(192.168.4.5)。

[root@proxy ~]# yum install -y keepalived

[root@proxy ~]# vim /etc/keepalived/keepalived.conf

global_defs {

router_id proxy1 //设置路由ID号

vrrp_iptables //不添加任何防火墙规则

} vrrp_instance VI_1 {

state MASTER //主服务器为MASTER(备服务器需要修改为BACKUP)

interface eth0 //定义网络接口

virtual_router_id 51

priority 100 //服务器优先级,优先级高优先获取VIP(实验需要修改)

advert_int 1

authentication {

auth_type pass

auth_pass 1111 //主备服务器密码必须一致

}

virtual_ipaddress { //谁是主服务器谁获得该VIP(实验需要修改) 1

92.168.4.80

}

}

[root@proxy ~]# systemctl start keepalived

!!!重要!!!

在全局配置global_defs{}中手动添加vrrp_iptables,即可解决防火墙的问题。

2)配置第二台代理服务器proxy(192.168.4.6)

[root@proxy2 ~]# yum install -y keepalived

[root@proxy2 ~]# vim /etc/keepalived/keepalived.conf

global_defs {

router_id proxy2 //设置路由ID号

vrrp_iptables //不添加任何防火墙规则

}

vrrp_instance VI_1 {

state BACKUP //主服务器为MASTER(备服务器需要修改为BACKUP)

interface eth0 //定义网络接口

virtual_router_id 51

priority 50 //服务器优先级,优先级高优先获取VIP

advert_int 1

authentication {

auth_type pass auth_pass 1111 //主备服务器密码必须一致

}

virtual_ipaddress { //谁是主服务器谁获得该VIP

192.168.4.80

}

}

[root@proxy2 ~]# systemctl start keepalived

!!!重要!!!

在全局配置global_defs{}中手动添加vrrp_iptables,即可解决防火墙的问题。

步骤三:修改DNS服务器

1)修改网站域名对应的解析记录,解析到新的VIP地址。

192.168.4.5为DNS服务器。

[root@proxy ~]# vim /var/named/lab.com.zone

$TTL 1D

@ IN SOA @ rname.invalid. (

0 ; serial

1D ; refresh

1H ; retry

1W ; expire

3H ) ; minimum

@ NS dns.lab.com.

dns A 192.168.4.5

www A 192.168.4.80

2)重启DNS服务

[root@proxy ~]# systemctl restart named

部署Ceph分布式存储

1. 问题

部署Ceph分布式存储,实现如下效果:

-

使用三台服务器部署Ceph分布式存储

-

实现Ceph文件系统共享

-

将网站数据从NFS迁移到Ceph存储

2. 方案

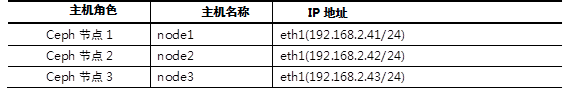

实验拓扑如图-2所示,做具体实验前请先配置好环境。

备注:实际操作中DNS服务代理服务器部署在同一台主机上(节约虚拟机资源)。主机配置如表-2所示。

3. 步骤

实现此案例需要按照如下步骤进行。

步骤一:准备实验环境

1)物理机为所有节点配置yum源服务器。

提示:ceph10.iso在/linux-soft/02目录。

[root@room9pc01 ~]# mkdir /var/ftp/ceph

[root@room9pc01 ~]# mount ceph10.iso /var/ftp/ceph/

2)在node1配置SSH密钥,让node1可用无密码连接node1,node2,node3

[root@node1 ~]# ssh-keygen -f /root/.ssh/id_rsa -N ”

[root@node1 ~]# for i in 41 42 43

do

ssh-copy-id 192.168.2.$i

done

3)修改/etc/hosts域名解析记录(不要删除原有的数据),同步给所有ceph节点。

[root@node1 ~]# vim /etc/hosts

192.168.2.41 node1

192.168.2.42 node2

192.168.2.43 node3

[root@node1 ~]# for i in 41 42 43

do

scp /etc/hosts 192.168.2.$i:/etc

done

4)为所有ceph节点配置yum源,并将配置同步给所有节点

[root@node1 ~]# cat /etc/yum.repos.d/ceph.repo

[mon]

name=mon

baseurl=ftp://192.168.2.254/ceph/MON

gpgcheck=0

[osd]

name=osd

baseurl=ftp://192.168.2.254/ceph/OSD

gpgcheck=0

[tools]

name=tools

baseurl=ftp://192.168.2.254/ceph/Tools

gpgcheck=0

[root@node1 ~]# yum repolist #验证YUM源软件数量

源标识 源名称 状态

Dvd redhat 9,911

Mon mon 41

Osd osd 28

Tools tools 33

repolist: 10,013

[root@node1 ~]# for i in 41 42 43

do

scp /etc/yum.repos.d/ceph.repo 192.168.2.$i:/etc/yum.repos.d/

done

5)所有节点主机与真实主机的NTP服务器同步时间。

提示:默认真实物理机已经配置为NTP服务器。

[root@node1 ~]# vim /etc/chrony.conf

… …

server 192.168.2.254 iburst

[root@node1 ~]# for i in 41 42 43

do

scp /etc/chrony.conf 192.168.2.$i:/etc/

ssh 192.168.2.$i “systemctl restart chronyd”

done

6)使用virt-manager为三台ceph虚拟机添加磁盘。每台虚拟机添加2块20G的磁盘。

步骤二:部署ceph集群

1)给node1主机安装ceph-deploy,创建工作目录,初始化配置文件。

[root@node1 ~]# yum -y install ceph-deploy

[root@node1 ~]# mkdir ceph-cluster

[root@node1 ~]# cd ceph-cluster

2)给所有ceph节点安装ceph相关软件包

[root@node1 ceph-cluster]# for i in node1 node2 node3

do

ssh $i “yum -y install ceph-mon ceph-osd ceph-mds”

done

3)初始化mon服务

[root@node1 ceph-cluster]# ceph-deploy new node1 node2 node3

[root@node1 ceph-cluster]# ceph-deploy mon create-initial

[root@node1 ceph-cluster]# ceph -s #查看结果

cluster 9f3e04b8-7dbb-43da-abe6-b9e3f5e46d2e

health HEALTH_ERR monmap e2: 3 mons at

{node1=192.168.2.41:6789/0,node2=192.168.2.42:6789/0,node3=192.168.2.43:6789/0}

osdmap e45: 0 osds: 0 up, 0 in

4)准备磁盘分区,创建journal盘,并永久修改设备权限。

[root@node1 ceph-cluster]# for i in node1 node2 node3

do

ssh $i “parted /dev/vdb mklabel gpt”

ssh $i “parted /dev/vdb mkpart primary 1 100%”

done

提示:下面的步骤在所有主机都需要操作(node1,node2,node3)

#临时修改权限:

[root@node1 ceph-cluster]# chown ceph.ceph /dev/vdb1

#永久修改权限:

[root@node1 ceph-cluster]# vim /etc/udev/rules.d/70-vdb.rules

ENV{DEVNAME}==”/dev/vdb1″,OWNER=”ceph”,GROUP=”ceph”

4)使用ceph-deploy工具初始化数据磁盘(仅node1操作)。

[root@node1 ceph-cluster]# ceph-deploy disk zap node1:vdc

[root@node1 ceph-cluster]# ceph-deploy disk zap node2:vdc

[root@node1 ceph-cluster]# ceph-deploy disk zap node3:vdc

5)初始化OSD集群。

[root@node1 ceph-cluster]# ceph-deploy osd create

node1:vdc:/dev/vdb1

//创建osd存储设备,vdc为集群提供存储空间,vdb1提供JOURNAL缓存,

//一个存储设备对应一个缓存设备,缓存需要SSD,不需要很大

[root@node1 ceph-cluster]# ceph-deploy osd create

node2:vdc:/dev/vdb1

[root@node1 ceph-cluster]# ceph-deploy osd create

node3:vdc:/dev/vdb1

[root@node1 ceph-cluster]# ceph -s #查看集群状态

cluster 9f3e04b8-7dbb-43da-abe6-b9e3f5e46d2e

health HEALTH_OK

monmap e2: 3 mons at {node1=192.168.4.11:6789/0,node2=192.168.4.12:6789/0,node3=192.168.4.13:6789/0}

election epoch 6, quorum 0,1,2 node1,node2,node3

osdmap e45: 3 osds: 3 up, 3 in

flags sortbitwise

pgmap v25712: 64 pgs, 1 pools, 86465 kB data, 2612 objects

508 MB used, 60 GB / 60 GB avail

64 active+clean

步骤三:部署ceph文件系统

1)启动mds服务

[root@node1 ceph-cluster]# ceph-deploy mds create node3

2)创建存储池(文件系统由inode和block组成)

[root@node1 ceph-cluster]# ceph osd pool create cephfs_data 128

[root@node1 ceph-cluster]# ceph osd pool create cephfs_metadata 128

[root@node1 ceph-cluster]# ceph osd lspools

0 rbd,1 cephfs_data,2 cephfs_metadata

3)创建文件系统

[root@node1 ceph-cluster]# ceph fs new myfs1 cephfs_metadata cephfs_data

[root@node1 ceph-cluster]# ceph fs ls

name: myfs1, metadata pool: cephfs_metadata, data pools: [cephfs_data ]

步骤四:迁移网站数据到ceph集群

1)卸载web1,web2,web3的NFS共享。

暂停服务防止有人实时读写文件。

[root@web1 ~]# /usr/local/nginx/sbin/nginx -s stop

[root@web2 ~]# /usr/local/nginx/sbin/nginx -s stop

[root@web3 ~]# /usr/local/nginx/sbin/nginx -s stop

[root@web1 ~]# umount /usr/local/nginx/html

[root@web2 ~]# umount /usr/local/nginx/html

[root@web3 ~]# umount /usr/local/nginx/html

[root@web1 ~]# vim /etc/fstab

#192.168.2.31:/web_share/html /usr/local/nginx/html/ nfs defaults 0 0

[root@web2 ~]# vim /etc/fstab

#192.168.2.31:/web_share/html /usr/local/nginx/html/ nfs defaults 0 0

[root@web3 ~]# vim /etc/fstab

#192.168.2.31:/web_share/html /usr/local/nginx/html/ nfs defaults 0 0

2)web服务器永久挂载Ceph文件系统(web1、web2、web3都需要操作)。

在任意ceph节点,如node1查看ceph账户与密码。

[root@node1 ~]# cat /etc/ceph/ceph.client.admin.keyring

[client.admin]

key = AQA0KtlcRGz5JxAA/K0AD/uNuLI1RqPsNGC7zg==

/etc/rc.local是开机启动脚本,任何命令放在该文件中都是开机自启。

[root@web1 ~]# mount -t ceph 192.168.2.41:6789:/ /usr/local/nginx/html/

-o name=admin,secret=AQA0KtlcRGz5JxAA/K0AD/uNuLI1RqPsNGC7zg==

[root@web1 ~]# echo ‘mount -t ceph 192.168.2.41:6789:/ /usr/local/nginx/html/

-o name=admin,secret=AQA0KtlcRGz5JxAA/K0AD/uNuLI1RqPsNGC7zg==’ >> /etc/rc.local

[root@web1 ~]# chmod +x /etc/rc.local

[root@web2 ~]# mount -t ceph 192.168.2.41:6789:/ /usr/local/nginx/html/

-o name=admin,secret=AQA0KtlcRGz5JxAA/K0AD/uNuLI1RqPsNGC7zg==

[root@web2 ~]# echo ‘mount -t ceph 192.168.2.41:6789:/ /usr/local/nginx/html/

-o name=admin,secret=AQA0KtlcRGz5JxAA/K0AD/uNuLI1RqPsNGC7zg==’ >> /etc/rc.local

[root@web2 ~]# chmod +x /etc/rc.local

[root@web3 ~]# mount -t ceph 192.168.2.41:6789:/ /usr/local/nginx/html/

-o name=admin,secret=AQA0KtlcRGz5JxAA/K0AD/uNuLI1RqPsNGC7zg==

[root@web3 ~]# echo ‘mount -t ceph 192.168.2.41:6789:/ /usr/local/nginx/html/

-o name=admin,secret=AQA0KtlcRGz5JxAA/K0AD/uNuLI1RqPsNGC7zg==’ >> /etc/rc.local

[root@web3 ~]# chmod +x /etc/rc.local

另一种解决方案,还可以通过fstab实现永久挂载。

提示:如果希望使用fstab实现永久挂载,客户端需要额外安装libcephfs1软件包。

[root@web1 ~]# yum -y install libcephfs1

[root@web1 ~]# vim /etc/fstab

… …

192.168.4.11:/ /usr/local/nginx/html/ ceph defaults,_netdev,name=admin,secret=AQCVcu9cWXkgKhAAWSa7qCFnFVbNCTB2DwGIOA== 0 0

第三种挂载方案:对于高可用的问题,可以在mount时同时写入多个IP。

临时命令:

[root@web1 ~]# mount -t ceph

192.168.4.11:6789,192.168.4.12:6789,192.168.4.13:6789:/ /usr/local/nginx/html

-o name=admin,secret=密钥

永久修改:

[root@web1 ~]# vim /etc/fstab

192.168.4.11:6789,192.168.4.12:6789,192.168.4.13:6789:/ /usr/local/nginx/html/

ceph defaults,_netdev,name=admin,secret=密钥 0 0

3)迁移NFS服务器中的数据到Ceph存储

登陆NFS服务器备份数据,将备份数据拷贝给web1或web2或web3,tar备份数据时注意使用-f选项保留文件权限。

[root@nfs ~]# cd /web_share/html/

[root@nfs html]# tar -czpf /root/html.tar.gz ./*

[root@nfs html]# scp /root/html.tar.gz 192.168.2.11:/usr/local/nginx/html/

登陆web1将数据恢复到Ceph共享目录

[root@web1 html]# tar -xf html.tar.gz

[root@web1 html]# rm -rf html.tar.gz

4)恢复web服务

[root@web1 ~]# /usr/local/nginx/sbin/nginx

[root@web2 ~]# /usr/local/nginx/sbin/nginx

[root@web3 ~]# /usr/local/nginx/sbin/nginx

部署Git版本控制系统

1. 问题

部署Git版本控制系统,管理网站代码,实现如下效果:

-

基于SSH协议的服务器

-

基于Git协议的服务器

-

基于HTTP协议的服务器

-

上传代码到版本仓库

2. 方案

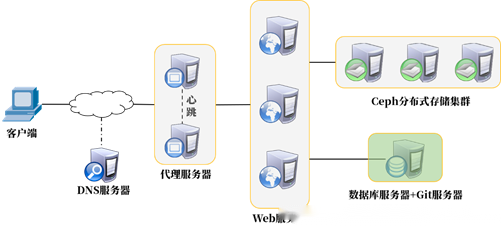

生产环境应该有一台独立的Git服务器,这里为了节约主机资源,我们使用数据库主机同时做完Git服务器,如图-1所示。

主机配置如表-1所示。

3. 步骤

实现此案例需要按照如下步骤进行。

步骤一:部署SSH协议的版本控制服务器

1)安装软件包,创建空仓库。

[root@database ~]# yum -y install git

[root@database ~]# mkdir /var/git/

[root@database ~]# git init –bare /var/git/wordpress.git #创建空仓库

2)登陆web1服务器克隆git仓库,上传网站代码到git服务器。

[root@web1 var]# git config –global push.default simple

[root@web1 var]# git config –global user.email [email protected]

[root@web1 var]# git config –global user.name “Your Name”

[root@web1 var]# cd /var/

[root@web1 var]# git clone [email protected]:/var/git/wordpress.git

[root@web1 var]# cd /var/wordpress

[root@web1 wordpress]# cp -a /usr/local/nginx/html/* ./

[root@web1 wordpress]# git add .

[root@web1 wordpress]# git commit -m “wordpress code”

[root@web1 wordpress]# git push

[email protected]’s password:<输入192.168.2.21主机root的密码>

步骤二:部署Git协议的版本控制服务器

1)安装软件包(192.168.2.21操作)

[root@database ~]# yum -y install git-daemon

2)修改配置文件,启动Git服务

[root@database ~]# vim /usr/lib/systemd/system/[email protected]

修改前内容如下:

ExecStart=-/usr/libexec/git-core/git-daemon –base-path=/var/lib/git –export-all –user-path=public_git –syslog –inetd –verbose

修改后内容如下:ExecStart=-/usr/libexec/git-core/git-daemon –base-path=/var/git –export-all –user-path=public_git –syslog –inetd –verbose

[root@database ~]# systemctl start git.socket

[root@database ~]# systemctl status git.socket

3)客户端测试(使用web2做完客户端主机,192.168.2.12)

在web2执行clone等同于是把代码又备份了一份。

[root@web2 ~]# cd /var/

[root@web2 var]# git clone git://192.168.2.21/wordpress.git

步骤三:部署HTTP协议的版本控制服务器

1)安装软件包(192.168.2.21操作)

[root@database ~]# yum -y install httpd gitweb

2)修改配置文件

[root@database ~]# vim /etc/gitweb.conf

$projectroot = “/var/git”; #添加一行

3)启动服务

[root@database ~]# systemctl start httpd

4)客户端验证

[root@room9pc01 ~]# firefox http://192.168.2.21/git

访问网页可以查看到wordpress仓库,点击tree菜单后可以看到如图-2所示的代码。

优化Web服务器

1. 问题

优化Web服务器,实现如下效果:

-

自定义网站404错误页面

-

升级nginx至1.15.8版本,开启status模块

-

编写日志切割脚本,实现每周五备份日志

-

开启gzip压缩功能,提高数据传输效率

-

开启文件缓存功能

2. 步骤

实现此案例需要按照如下步骤进行。

步骤一:自定义404错误页面

1)优化前测试(客户端访问一个不存在的页面)。

[root@room9pc01 ~]# firefox http://www.lab.com/git

2)修改Nginx配置文件,自定义错误页面

[root@web1 ~]# vim /usr/local/nginx/conf/nginx.conf

error_page 404 /404.html; //自定义错误页面

[root@web2 ~]# vim /usr/local/nginx/conf/nginx.conf

error_page 404 /404.html; //自定义错误页面

[root@web3 ~]# vim /usr/local/nginx/conf/nginx.conf

error_page 404 /404.html; //自定义错误页面

3) 重启nginx

[root@web1 ~]# /usr/local/nginx/sbin/nginx -s reload

[root@web2 ~]# /usr/local/nginx/sbin/nginx -s reload

[root@web3 ~]# /usr/local/nginx/sbin/nginx -s reload

步骤二:升级nginx版本,开启status模块

1)配置、编译新的nginx(web1、web2、web3做相同操作,下面以web1为例)

[root@web1 ~]# tar -xf nginx-1.15.8.tar.gz

[root@web1 ~]# cd nginx-1.15.8

[root@web1 nginx-1.15.8]# ./configure

–with-http_ssl_module

–with-http_stub_status_module

[root@web1 nginx-1.15.8]# make

2)备份老版本nginx,更新新版本nginx

[root@web1 nginx-1.15.8]# mv /usr/local/nginx/sbin/nginx{,.old}

[root@web1 nginx-1.15.8]# cp objs/nginx /usr/local/nginx/sbin/

3)修改配置文件

[root@web1 ~]# vim /usr/local/nginx/conf/nginx.conf

… …

location /status {

stub_status on;

allow 192.168.2.0/24;

deny all;

}

… …

4)升级或重启服务

注意:必须在nginx-1.15.8源码包目录下执行make upgrade命令。

[root@web1 nginx-1.15.8]# make upgrade

或者手动执行killall命令杀死进程后重新启动

[root@web1 ~]# killall nginx

[root@web1 ~]# /usr/local/nginx/sbin/nginx

步骤三:编写日志切割脚本

1)编写脚本(以web1为例)

[root@web1 ~]# vim /usr/local/nginx/logbak.sh

#!/bin/bash

date=`date +%Y%m%d`

logpath=/usr/local/nginx/logs

mv $logpath/access.log $logpath/access-$date.log

mv $logpath/error.log $logpath/error-$date.log

kill -USR1 $(cat $logpath/nginx.pid)

2)创建计划任务

[root@web1 ~]# crontab -e

03 03 * * 5 /usr/local/nginx/logbak.sh

步骤四:对页面进行压缩处理

1)修改Nginx配置文件

[root@proxy ~]# cat /usr/local/nginx/conf/nginx.conf

http {

.. ..

gzip on; //开启压缩

gzip_min_length 1000; //小文件不压缩

gzip_comp_level 4; //压缩比率

gzip_types text/plain text/css application/json application/x-javascript text/xml application/xml application/xml+rss text/javascript;

//对特定文件压缩,类型参考mime.types

.. ..

}

步骤五:服务器内存缓存

1)如果需要处理大量静态文件,可以将文件缓存在内存,下次访问会更快。

http {

open_file_cache max=2000 inactive=20s;

open_file_cache_valid 60s;

open_file_cache_min_uses 5;

open_file_cache_errors off;

//设置服务器最大缓存2000个文件句柄,关闭20秒内无请求的文件句柄

//文件句柄的有效时间是60秒,60秒后过期

//只有访问次数超过5次会被缓存

}